Intelligente Datenverarbeitung

Big Data, KI und Machine Learning

Anwendungsbeispiele

- Zielgruppen in Verkaufszahlen bestimmen

- Angebots-Empfehlungen für Zielgruppen

- Vorhersage von Käuferverhalten

- Optimierung, z.B. Benzinverbrauch minimieren

- Klassifzierung von Bewegung im Fitness-Armband

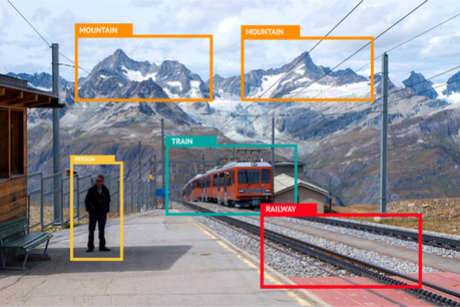

- Objekte in Bildern erkennen

- Optimierung von Geschäftsprozessen

- Intelligente Bots, Chat Bots

- Handschrifterkennung

- Spracherkennung

- Gesichtserkennung, Mimik, Gestig

- Autonome Fahrzeuge und automatisches Fahren

- Smart Devices

Big Data

Einerseits werden Computer unaufhaltsam immer schneller, andererseits erhöht sich die Menge an Daten, die erzeugt werden. Dennoch enthalten die Daten tatsächlich mehr Information, sie sind detailreicher und liegen häufig erstmals digital vor.

Eigentlich greift man hier auf alte, bewährte und gut verstandene Methoden zurück. Es ist aber die heute verfügbare Rechenleistung, die so viel größer und erschwinglicher geworden ist. Größte Datenmengen können parallel auf mehreren Rechnern gleichzeitig verarbeitet werden. Feinere Details zu verarbeiten führt zu zuverlässigeren Ergebnissen. Oder Ergebnisse lassen sich "in realtime" berechnen, die Folgen von Entscheidungen kann interraktiv simuliert werden.

Künstliche Intelligenz

Die Einsatzmöglichkeiten für "intelligente" Datenverarbeitung schienen schon immer vielfältig. Und tatsächlich haben es bereits Assistenzsysteme und intelligente Workplaces in den realen Breiteneinsatz geschafft. Ursprünglich basierte die Idee auf der Vorstellung, es sei allein mit logischen Operationen und Rechenleistung möglich, "Expertensysteme" zu bauen: Anhand ihrer Regelsammlung sollen Fälle klassifizieren, Vorhersagen getroffen oder Entscheidungsoptionen herausarbeiten werden - wenn nicht sogar Entscheidungen getroffen werden. Diese Vorstellung verbindet sich teils sogar mit dem Anspruch, Entscheidungen schneller, präziser und sachlicher treffen zu können. Es ist klar, dass sich dahinter ein erhebliches ethisches Problem verbirgt. Der Fokus der frühen "Künstlichen Intelligenzen" beschränkte sich allerdings auf Spezialwissen und einen eher eingegrenzten Anwendungsbereich, der vor allem erst in Regeln repräsentiert werden muss. Man weiss heute, dass es viel häufiger mehr braucht als das logische Rechenwerk und konnte gerade dadurch Fortschritte erzielen. Auch wenn es immer wieder "Rückschläge" gibt, steigende Rechenpower und bessere Methoden lassen Computer dennoch letztlich immer intelligenter werden. Es wäre nicht die erste Technologie, die lange brauchte um zu reifen. Doch plötzlich ist sie da, auf breiter Basis. Das scheint dann häufig um so überraschender.

bekannte Beispiele

- Assistenzsysteme

- Expertensysteme

- Wissensspeicher

- Autonome Roboter

- Intelligente Produktionssteuerungen

Schwerpunkte

- Regelwerke

- Entscheidungsbäume

- Wissensrepräsentationen

- Klassifizierung von Objekten

Machine Learning

Daten immer schneller zu verarbeiten ist die eine Fortschrittsrichtung. Es steckt viel Aufwand darin, sich immer wieder damit zu beschäftigen wie die Daten zu verarbeiten sind: Das Modell zu entwickeln, das hinter den Daten steht, auf dem dann Programme basieren, die die Daten verarbeiten. Auch das sollten Computer können - selbst übernehmen, indem sie lernfähig sind, anpassungsfähig - etwas "intelligenter". Das ist eine etwas größere Herausforderung, wie sich gezeigt hat. Aber es gibt Beispiele, da funktioniert das sehr gut. Die Verfahrensweisen konnten nicht nur verfeinert werden. Mit immer mehr und günstiger Rechenleistung finden die Verfahren immer häufiger Anwendung und ein breiteres Einsatzfeld.

- Überwachtes Lernen: Die Maschine bekommt während der Lernphase eine Rückmeldung ob ihre Ergebnisse richtig oder falsch sind. Anhand der Rückmeldung verfeinert die Maschine ihre Berechnungseinstellungen. Diese Herangehensweise kann eingesetzt werden, wenn ein gewünschtes Ergebnis angegeben werden kann, d. h. Vorwissen vorhanden ist und so etwas wie ein "Lernziel" angegeben werden kann.

- Unüberwachtes Lernen: Der Maschine wird kein Vorwissen mitgegeben, es ist kein direktes Lernziel bekannt. Zweck ist hier, dass die Maschine in den Daten Strukturen entdeckt, und darauf selbst sinnvolle Kategorien bildet, Aktionen ausführt oder Vorhersagen trifft.

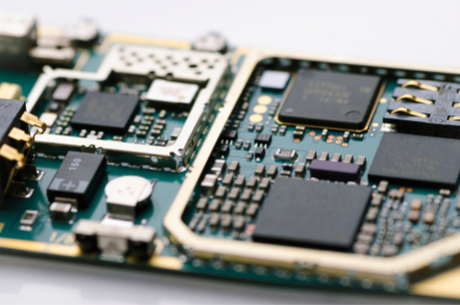

Sparpotenziale: Low Cost Runtime Device

Nach erfolgreicher Lernphase kann der "Algorithmus" auf ein Anwendungs-Device transferiert werden. Die "Intelligenz" steckt in den Parameter einer Folge eher simpler Berechnungen. Nicht selten leisten dies schon Micro-Chips kleiner Baugröße mit geringem Leistungsbedarf. Klassische Systeme müssen hingegen auf der Grundlage ihrer Modelle komplizierte Berechnungen in Echtzeit durchführen.

Schöne Grüße vom "traveling salesman" und seinem Problem

Immer dann, wenn es schwieriger als gedacht wird:

Dann, wenn bloße Rechenleistung versagt

Die Aufgabe hört sich einfach an: "Besuchen Sie die Städte Hamburg, München, Köln, Frankfurt, Berlin und Stuttgart in der Reihenfolge, die den insgesamt kürzesten Reiseweg ergibt." Man kommt schnell darauf: Von einer Stadt die jeweils nächstgelegene anzufahren, ergibt nicht die schlechteste Route, es ist aber auch nicht automatisch die insgesamt kürzeste. Rechenknecht Computer kann alle Kombinationen berechnen und sollte leicht die kürzeste Route bestimmen können. Leider steigt die Anzahl der Berechnungen mit der Zahl der Städte so stark an, daß bei 15 Städten über 43 Milliarden und bei 18 Städten bereits über 177 Billionen Routen zu berechnen sind. Es ist immer nur die Frage, bei welcher Zahl von Städten alle verfügbare Rechenleistung nicht mehr ausreicht, die Lösung zu bestimmen.

Nun kann man darüber nachdenken, man kann das vielleicht reparieren. Es müssen vielleicht nicht alle Routen berechnet werden: Ausgehend von einer Route variiert man ein wenig - tauscht gezielt die Reihenfolge nur zweier Städten aus - und entscheiden, ob die neue Route besser oder schlechter ist. D. h. die Route wird von einem Schritt zum nächsten optimiert. Der Algorithmus endet, wenn er keine bessere Route mehr findet. Es ist aber nicht ausgeschlossen, dass der Algorithmus auf seinem Weg zum Optimum wichtige Bereiche ausgelassen hat - Bereiche, die zunächst schlechter scheinen, nach den ungünstigen Schritten dann aber doch zu noch besseren Werten geführt hätte. Der Algorithmus hat nur ein "lokales" Optimum gefunden, nicht das "globale" Optimum. Mit weiteren Verfahren wie "simulated annealing" kann man auch dieser Herausforderung begegnen. Aber der Aufwand steigt und steigt.

Das "traveling salesman problem" ist eins der Musterbeispiele der Informatik, das sehr gut erforscht wurde und sehr gute Erkenntnise über grundsätzlich mögliche Probleme bei Berechnungen bringt, d. h. hier: wenn man sich auf ein kombinatorisches Berechnungsproblem einlässt. Stellt man Personen vor die Aufgabe oben, wählen sie ohne allzu lange zu probieren eine Route aus: Es ist nicht die optimalste Route, aber überraschend häufig sehr nahe daran. Auch hier wird ein Verfahren angewendet. Der Mensch hat gelernt, mit solchen Fragestellungen umzugehen, gut umzugehen. Er nutzt aber offensichtlich andere Vorgehensweise. Nicht nur hier - häufig.

Das Beispiel zeigt: Obwohl die Computer heutiger Architektur bzw. die Programme, die auf ihnen laufen, so weit entwickelt sind - es ist nicht die einzige Art, Probleme zu lösen. Imgrunde ist es sogar eine extrem spezielle Art und Weise. Es gibt viel mehr andere Herangehensweisen - "Algorithmen" - die anders funktionieren. Viel ist erforscht, das fängt schon bei der Anwendung reiner Mathematik und weiterer Erkenntnisse an, vieles noch nicht - sagen wir: "ausprobiert und getestet", viel noch gar nicht klar, und bei wieder anderem liegt gerade darin der Reiz, dass man ein Verfahren nutzen kann ohne sich groß damit beschäftigen zu müssen, was da abläuft.

Die Technologie macht Angst. Aus den verschiedensten Gründen. Zumindest aber weil in Bereichen Risiken nicht eingeschätzt werden und weil eine Domäne betreten wird, die bisher allein dem Mensch vorbehalten war. Das kann nicht ernst genug genommen werden. Es darf aber nicht darüber hinweg täuschen, welche Chancen darin liegen, die Technologie dort auszubauen, wo sie nötigen Fortschritt und reichlich Nutzenpotential bietet: Rechner leichter bedienbar zu machen und effektivere Werkzeuge für unsere Informations-/Wissensgesellschaft zu entwickeln.